Was wäre, wenn Datenkatalog, Data Governance und Data Warehouse Automation in einem Rutsch erledigt wären?

Das magische Triple kann jetzt ganz leicht und unaufwändig erreicht werden: mit dem

d.vg – dataspot. vault generator

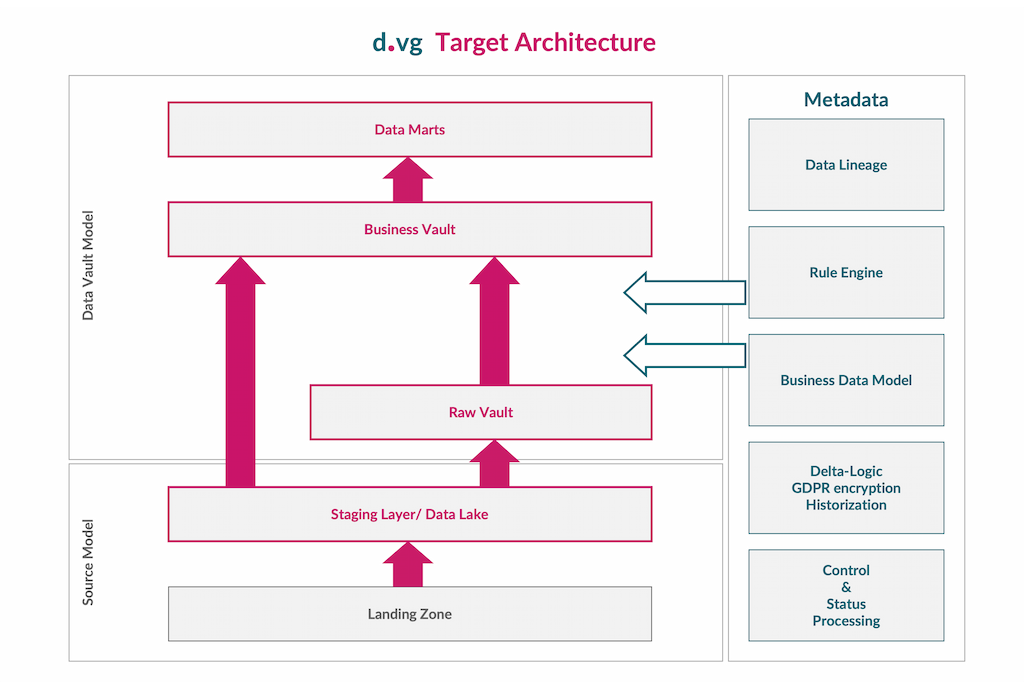

Egal, ob es sich um die Datenbereitstellung für Data Lakes und analytische Plattformen handelt, Source-Daten harmonisiert und integriert im Data Warehouse zur Verfügung gestellt werden oder Data Mesh über verschiedenste Datendomänen implementiert wird. Mit minimalem Aufwand können Zieldatenstrukturen in dataspot. modelliert und mit den eingelesenen Source-Datenstrukturen verknüpft werden. Der d.vg legt das Zielmodell an, generiert die Import-Jobs und kümmert sich vollautomatisch um die Beladung – alles per Knopfdruck mit Data Lineage out-of-the-box, technischer Historisierung und DSGVO-Verschlüsselung.

Will man Daten für Analysen und analytische Modelle zur Verfügung haben, soll es immer ganz schnell gehen. Sehr oft werden daher Files und andere Datenbestände durch die Data Scientists selbst auf individuelle Plattformen gezogen, um nicht warten zu müssen. Und wenn die Daten nach der Erstanalyse einmal verstanden sind, geht dieses Wissen meist verloren. Die erstellten Data Products erreichen zwar umgehend ihre Zielgruppe, die Wiederverwendbarkeit wird jedoch vernachlässigt.

Mit dem d.vg gehört dies der Vergangenheit an, denn auf Knopfdruck werden die Datenstrukturen auf der Zielplattform automatisiert angelegt, befüllt und als Metadaten abgelegt, um die gewonnenen Erkenntnisse auch gleich daran zu dokumentieren. Die daraus erstellten Data Products können dann mit wenigen Clicks im Data Product Catalog als Metadaten angelegt, beschrieben und allen Zielgruppen zur Verfügung gestellt werden. Data Lineage Information erhält man dadurch ohne zusätzlichen Aufwand quasi gratis dazu. Damit ist nicht nur Data Governance gewährleistet, sondern garantiert, dass die Daten verstanden und genutzt werden.

Eine integrierte und harmonisierte Sicht auf die Unternehmensdaten ist die Basis für jegliche Nutzung von zuverlässigen Daten durch interne und externe Datenkonsument:innen. Die Übersetzungsarbeit zwischen Daten in den Source Systemen und der fachlichen Sicht, die übergreifend ist und von allen verstanden wird, erfolgt durch die Erfassung der notwendigen Mappings direkt als Metadaten in dataspot.

Die dafür erforderliche Logik kann von fachlichen Expert:innen selbst in dataspot. erstellt werden, da dataspot. eben genau für diese Expert:innen ausgerichtet ist. Die Beschreibungen im Fachdatenmodell bilden somit die fachliche Transparenz für alle, die Daten aus dem Data Warehouse beziehen möchten, Data Products die in dataspot. aus dem Fachdatenmodell abgeleitet werden erhalten automatisch ihre Data Lineage und Datenqualität sowie Datenverantwortung können an einer Stelle in dataspot. hinterlegt werden.

Einmal im Fachdatenmodell samt Mappings definiert, sinkt der Implementierungsaufwand für die Daten gegen 0 – der d.vg übernimmt sowohl die Generierung der Datenstrukturen im Data Warehouse als auch den regelmäßigen Import der Daten und ihre Transformation. Programmierleistungen wie Delta-Bildung, Historisierung und DSGVO-Verschlüsselung sind dabei bereits inkludiert, das Zieldatenmodell wird automatisch als Data Vault gebildet.

Auch für Data Mesh benötigt es eine unternehmensweit harmonisierte, fachliche Sicht auf die Daten – klar getrennt nach Datendomänen der einzelnen Data Owner, die im Fachdatenmodell den Rahmen für alle Geschäftsobjekte bilden – aber dennoch mit einer integrierten Gesamtsicht. Direkt im Fachdatenmodell werden die Mappings zu den operativen Source Daten erstellt – der d.vg generiert daraus vollautomatisch die Datenstrukturen auf der Zielplattform und importiert regelmäßig die angelieferten Daten – Historisierung und DSGVO-Verschlüsselung inklusive.

Durch einfache Selektion der Daten aus dem Fachdatenmodell werden die Data Products in dataspot. für die Zielgruppen innerhalb und außerhalb der Datendomäne konzipiert und können dadurch sehr schnell implementiert werden. Die dabei entstehende Data Lineage und die Beschreibungen im Fachdatenmodell gewährleisten dabei ein optimales Verständnis der Data Products durch die Datennutzer:innen – das ist unser Verständnis von «Data as a Product».

dataspot. ist ein innovatives Unternehmen mit Sitz in Wien, Linz, Basel, Zürich und Berlin, das sich zum Ziel gesetzt hat, seinen Kund:innen den Wert ihrer Daten aus einem fachlichen Blickwinkel erkennen zu lassen.